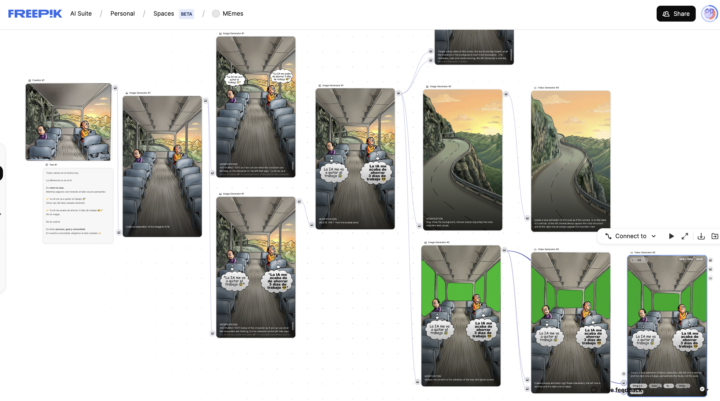

Animar Memes con Inteligencia Artificial

Entre los contenidos que me reocmendo la IA según mi data en redes sociales de 2025 es que empezara a incluir contenidos tipo memes pero que intentara generar temas de opinion, con ello. Asi que me volque a la IA nuevamente a que me lo asistiera y les comparto el proceso. 1. Le envie el meme original a CHAT GPT y le conte lo que queria hacer, y le pedi me generara 10 versiones de textos para utilizar en el meme y tuviera el mismo contexto. 2. Luego lo lleve a Freepik, lo converti en imagen vertical 3. Luego intenté animarlo directamente, pero me dio muchos errores, por lo que opté por separar el fondo para animarlo de forma independiente y el bus colocarle pantalla verde para removerlo despues. 4. Al final solo dejé el bus sin movimiento y que se moviera el fondo. 5. Elimine el fondo verde con Canva 6. Lo envie a capcut y le coloque una musica que había generado previamente. Si notan el fondo no es un loop perfecto, una pequeña imperfección válida par aun video que pude animar en 10 minutos. Que habrian hecho diferente? o mejor?

2

0

🥇 TOP HERRAMIENTAS DE IA QUE USARÉ EN 2026

Si hoy tuviera que quedarme solo con unas pocas herramientas de inteligencia artificial para todo 2026… estas serían. No porque estén de moda, sino porque me funcionan de verdad. Y sí, esto va a cambiar… pero si hoy arrancas o ya estas usándolas, vas muy bien. 🔹 1. Generación de imágenes: Para todo lo visual, estoy usando Google Gemini Nano Banana. https://gemini.google.com/ - La calidad es impresionante - Mantiene muy bien el contexto - Personas, objetos y estilos consistentes - Sirve para: Afiches Artes para redes Fotos tipo estudio Escenarios Visuales publicitarios 🔹 2. Generación de video Para video, hoy combino Kling con Google Veo. https://klingai.com/global/ https://labs.google/fx/es-419/tools/flow - Uso Kling y Google Veo 3 - Calidad muy alta - Buen manejo de movimiento - Consumo de créditos razonable - Ideal para: Anuncios Clips cinemáticos Videos explicativos Contenido creativo 🔹 3. Lip Sync (labios que sí convencen) Para lip sync, lo que mejor me ha funcionado es Kling junto con Hedra. https://klingai.com/global/ https://hedra.com - Movimientos más naturales - Menos efecto ‘muñeco’ - Ideal para: Avatares Videos hablados Contenido educativo 🔹 4. Analizar contenido y estudiar información Para hacer preguntas directas a mis propios documentos, videos o investigaciones, uso Google Notebook LM. https://notebooklm.google/ - Perfecto para: Estudios Análisis profundo Preguntar sobre tu propio contenido - Muy útil cuando trabajas con: PDFs Videos Documentación larga 🔹 5. Automatizaciones y agentes de IA Para automatizar procesos y crear agentes, uso Make y n8n. https://make.com/ https://n8n.io/ - Conectan herramientas - Automatizan tareas repetitivas - Ideal para: Marketing Operaciones Flujos internos Escalar trabajo sin más personas

Automatiza con IA: miniaturas para YT, diseños para tiktok/ig y portadas de articulos en Linkedin

Sesión de QnA y Guías de Conversemos Acerca de IA - 2 de Enero 2026 ⏱️ Timestamps con aprendizajes clave 00:08 – Máquina de miniaturas de Youtube: pegar transcripción → generar thumbnails: automatizar el diseño base sin empezar desde cero 06:00 – Outro para YouTube con logo y espacios de videos: generar propuestas y luego animarlas 07:07 – Solución al “espacio negro” en vertical (TikTok/IG): crear franja/barra de marca y textura para que el video se vea limpio 09:35 – Portadas para artículos (LinkedIn): resumen vs artículo completo y cómo iterar sobre un 80% listo sin rehacer 12:30 – Convertir logos a negativo en Canva (Duotono): método rápido y truco por capas para mantener detalles de color

Cómo crear escenas de producto profesionales con IA (para anuncios, reels y comerciales)

En este video te muestro el proceso completo que usamos para crear escenas de producto modernas y profesionales utilizando inteligencia artificial. Coméntenme si este tipo de contenido les resulta provechoso para seguir haciéndolo Este mismo flujo lo puedes aplicar a cualquier tipo de negocio: comida, tecnología, ecommerce, servicios, marcas personales y más. El framework en 5 pasos (resumen rápido) ] - Imagen real del producto (aunque no sea perfecta) - Referencia visual clara (Pinterest, stock, ideas propias) - Generación de fotos base con IA - Animación (tomas orbitales, zoom, variaciones) - Edición final en CapCut o Canva Si puedes hacer esto una vez, puedes hacerlo para cualquier producto.

3

0

Prompt para ordenar tus objetivos en 2026

Algo que hago siempre es trabajar mis metas por trimestres. Cada 3 meses me siento, reviso qué viene y ajusto el rumbo. Pero una vez al año hago algo distinto: me tomo el tiempo de mirar hacia atrás, entender cómo fue el año completo, y desde ahí definir las metas generales del siguiente año, además de aterrizar con claridad el próximo trimestre. Hace unos días hice ese ejercicio. Ya lo había hecho ante, de hecho, lo hice a inicios de 2025, y fue clave para lograr muchas de las cosas que construí este año, pero esta vez fue diferente. Con todo lo que ha avanzado la inteligencia artificial, el proceso fue: más claro, más rápido y mucho más eficiente La primera revisión que hice solo, con papel y notas, me dejó ideas sueltas. Cuando repetí el ejercicio usando IA, la claridad fue otra. Me ayudó a ordenar pensamientos, detectar contradicciones y priorizar de verdad. Incluso como ya me conoce me dijo "respetusamente" que debia mover cosas para el Q2 Por eso hoy quiero compartirles el PROMPT que usé. No es para todo el mundo. Pero si estás en un punto donde tienes muchas ideas y necesitas estructura, puede servirte muchísimo. Si lo usas, cuéntame si te funcionó 👇 --- PROMPT: Actúa como un coach estratégico y de vida, directo pero empático.Tu objetivo es ayudarme a ordenar mis ideas, depurar mis metas y convertirlas en un plan realista, alineado con quién soy, cómo vivo hoy y la energía que tengo disponible. Voy a compartir contigo: - Mis metas anuales - Mis metas para un trimestre - Mis responsabilidades personales, familiares y profesionales INSTRUCCIONES CLAVE (MUY IMPORTANTE): 1. No asumas nada. 2. Antes de dar conclusiones finales, hazme todas las preguntas necesarias para entender: 3. Cuestiona mis metas con criterio, incluso si suenan bien. 4. No me des respuestas genéricas ni motivacionales.Quiero análisis, ajustes concretos y decisiones claras. 5. Ayúdame a: FORMATO DE RESPUESTA QUE ESPERO: - Análisis honesto de mis metas (qué está bien, qué no) - Recomendaciones claras (qué mantener, quitar o mover) - Propuesta de metas ajustadas - Identificación de sobrecarga o contradicciones - Sugerencias prácticas adaptadas a mi realidad - Si aplica, un plan trimestral tipo 12-Week Year

1-30 of 93

powered by

skool.com/ia-y-marketing-digital-6311

Domina estrategias de marketing con Inteligencia Artificial. Potencia tu negocio y mantente al frente en el competitivo mundo del marketing digital

Suggested communities

Powered by