Activity

Mon

Wed

Fri

Sun

Apr

May

Jun

Jul

Aug

Sep

Oct

Nov

Dec

Jan

Feb

Mar

What is this?

Less

More

Memberships

AI STARS LEAGUE

80 members • Free

11 contributions to AI STARS LEAGUE

𝗛𝗔𝗖𝗜𝗔 𝗠𝗢𝗗𝗘𝗟𝗢𝗦 𝗗𝗘 𝗜𝗔 𝗤𝗨𝗘 𝗥𝗔𝗭𝗢𝗡𝗘𝗡 𝗖𝗢𝗠𝗢 𝗛𝗨𝗠𝗔𝗡𝗢𝗦

Sección Noticias No pienso que las maquinas puedan razonar como los humanos, es una forma de hablar. Pero me atrae mucho como los algoritmos y técnicas evolucionan para simular ese pensamiento. Ya he avanzado en otros post estudios al respecto, como en el que hable de los "LARGE CONCEPT MODELS" (LCMS). https://lnkd.in/drP7zmfS En los últimos años, la IA ha avanzado a pasos agigantados, sobre todo desde la llegada de ChatGPT en 2022. Durante un tiempo, la carrera se centró en crear modelos cada vez más grandes y potentes, lo que llevó a enormes inversiones en centros de datos. Sin embargo, recientemente se ha visto que simplemente aumentar el tamaño de los modelos ya no garantiza mejores resultados. El rendimiento de algunos de los modelos más grandes, como GPT-4.5, no cumplió con las expectativas, lo que ha llevado a un cambio de enfoque en la investigación de IA. Ahora, el reto no es solo hacer modelos más grandes, sino hacer que piensen de forma más parecida a los humanos. En vez de buscar respuestas rápidas, los investigadores están enseñando a las IA a tomarse su tiempo y razonar paso a paso. Un ejemplo de esto es la técnica llamada “cadena de pensamiento”, que permite a los modelos descomponer un problema en pasos intermedios antes de llegar a una solución. Este método ha demostrado mejorar mucho el rendimiento en tareas de lógica y matemáticas. Gracias a este enfoque, han surgido modelos de nueva generación como OpenAI o3, Google Gemini 2.5, Anthropic Claude 3.7 y DeepSeek R1, que destacan por su capacidad de razonamiento. Además, la comunidad científica está desarrollando variantes como “árbol de pensamiento” o “lógica de pensamiento”, todas inspiradas en cómo las personas abordan problemas complejos. El funcionamiento de este razonamiento se basa en que los modelos, en lugar de dar una respuesta directa, generan una serie de pasos lógicos antes de llegar a la conclusión. Incluso se utilizan técnicas de aprendizaje por refuerzo para premiar a los modelos cuando sus razonamientos intermedios llevan a una mejor respuesta final. Así, la IA aprende a dividir problemas grandes en partes más pequeñas y a corregir errores sobre la marcha, imitando estrategias humanas.

🔥 MANUAL DEL RETO: CONSTRUYE TU IA EN LOCAL 🔥El comienzo de los verdaderos arquitectos del futuro.

⚠️ Este no es un simple reto. Es una misión de alto nivel.Una travesía para los que no se conforman con usar tecnología…🌌 …sino que quieren crear la suya propia. 📜 LO QUE TIENES EN MANOS AHORA ES UN MANUAL DE REFERENCIA.Un ejemplo. Una brújula.🧭 Pero no es un mapa obligatorio. Porque cada equipo, cada jugador, cada mente…tiene la libertad de crear su IA como crea conveniente.📂 El documento que compartimos es solo una base para inspiraros.Pero el verdadero objetivo es: ✅ Investigar. ✅ Probar. ✅ Romper cosas. ✅ Rearmarlas. ✅ APRENDER DE VERDAD. 🎯 ¿POR QUÉ ESTE RETO ES TAN IMPORTANTE? Porque lo que viene es aún más grande. Se acercan desafíos donde deberéis construir IAs reales para startups y empresas nacidas dentro de esta misma liga.Y ahí no habrá margen para las dudas. Este reto es la fase cero.⚙️ El campo de entrenamiento donde forjamos a los futuros constructores de la nueva era. 👾 Construir una IA en local 🧠 Sin plataformas externas 💻 Sin depender de GPU 🎙️ Que hable, entienda y decida con tu equipo Es el primer paso hacia algo mucho más grande. 📥 Aquí tenéis el manual. Leedlo, usadlo, ignóralo si queréis.Pero que vuestra IA nazca de vuestra visión, de vuestros errores, de vuestra genialidad.Eso es lo que buscamos.Eso es lo que necesitamos. 🔥 El conocimiento real nace de enfrentarse al abismo con las manos desnudas.Esta es la Liga AI Stars.No solo jugamos con IA.La creamos. La entendemos. La dominamos.

⚔️ RETO LEGENDARIO: CREA TU PROPIA IA EN LOCAL ⚙️

¡UN NUEVO GUERRERO PARA TU EQUIPO! Ha llegado el momento… De dejar de ser solo un usuario, y convertirte en CREADOR DE TECNOLOGÍA. Este reto no es para todos. Es para los valientes. Para los que no se conforman. Para los que están listos para construir el futuro con sus propias manos. IMAGINA ESTO: Un portátil común. ✅ Con tus datos. ✅ En tu idioma. ✅ Para tu equipo. Una IA local, hecha a tu medida. ¡Una mente artificial que se convierte en un jugador más en tu escuadra! OBJETIVO: Crear una IA desde cero en local… y entrenarla para que piense, hable y juegue contigo. Una semana para cada etapa. Tres semanas para la leyenda. CALENDARIO DEL RETO Inicio: 11.05.2025 Final: 01.06.2025 (¡presentación en directo en Kick! 📺) SEMANA 1 – El despertar del sistema Entiende su alma. Personaliza su esencia. Dale identidad. SEMANA 2 – La voz del nuevo guerrero Construye su voz. Haz que hable como uno más del escuadrón. SEMANA 3 – Entrenamiento y batalla Aliméntala con datos reales. Entrénala para tomar decisiones. Hazla luchar junto a ti. ¿CÓMO DEMUESTRAS TU HAZAÑA? ¿Te atreves a presentar tu IA en directo y que hable con él público y otros equipos? ¡Inspira a otros a cruzar la misma frontera que tú conquistaste! Los entrenadores recibirán el documento técnico el 12 de mayo. Desde ahí, solo depende de tu coraje, tu creatividad y tu visión. Porque en esta liga… no solo jugamos con IA… la CREAMOS. ¡BIENVENIDO AL RETO MÁS GRANDE DE LA LIGA AI STARS! ¿Estás listo para hacer historia? El futuro no se espera… SE CONSTRUYE.

🔥 ¡𝗦𝗘 𝗘𝗦𝗖𝗨𝗖𝗛𝗔𝗡 𝗟𝗢𝗦 𝗧𝗔𝗠𝗕𝗢𝗥𝗘𝗦 𝗗𝗘 𝗟𝗔 𝗛𝗜𝗦𝗧𝗢𝗥𝗜𝗔! 🔥

Hoy no es un día cualquiera... 𝗛𝗢𝗬 𝗡𝗔𝗖𝗘 𝗟𝗔 𝗣𝗥𝗜𝗠𝗘𝗥𝗔 𝗙𝗘𝗗𝗘𝗥𝗔𝗖𝗜𝗢́𝗡 𝗡𝗔𝗖𝗜𝗢𝗡𝗔𝗟 𝗗𝗘 𝗟𝗔 𝗔𝗜 𝗦𝗧𝗔𝗥𝗦 𝗟𝗘𝗔𝗚𝗨𝗘. 🇨🇴 ¡𝗖𝗢𝗟𝗢𝗠𝗕𝗜𝗔, 𝗧𝗘 𝗔𝗖𝗔𝗕𝗔𝗦 𝗗𝗘 𝗖𝗢𝗥𝗢𝗡𝗔𝗥 𝗖𝗢𝗠𝗢 𝗟𝗔 𝗣𝗥𝗜𝗠𝗘𝗥𝗔 𝗟𝗜𝗚𝗔 𝗡𝗔𝗖𝗜𝗢𝗡𝗔𝗟 𝗢𝗙𝗜𝗖𝗜𝗔𝗟 𝗗𝗘𝗟 𝗠𝗨𝗡𝗗𝗢! ⚔️ ¿Qué significa esto? Que por primera vez, 𝘂𝗻 𝗽𝗮í𝘀 𝗲𝗻𝘁𝗲𝗿𝗼 𝘀𝗲 𝗼𝗿𝗴𝗮𝗻𝗶𝘇𝗮 𝗰𝗼𝗺𝗼 𝘂𝗻𝗮 𝗳𝘂𝗲𝗿𝘇𝗮 𝗶𝗺𝗽𝗮𝗿𝗮𝗯𝗹𝗲 𝗱𝗲𝗻𝘁𝗿𝗼 𝗱𝗲𝗹 𝗺𝗼𝘃𝗶𝗺𝗶𝗲𝗻𝘁𝗼 𝗴𝗹𝗼𝗯𝗮𝗹 𝗱𝗲 𝗹𝗮 𝗔𝗜 𝗦𝘁𝗮𝗿𝘀 𝗟𝗲𝗮𝗴𝘂𝗲. 📜 Así nace 𝗹𝗮 𝗙𝗲𝗱𝗲𝗿𝗮𝗰𝗶𝗼́𝗻 𝗖𝗼𝗹𝗼𝗺𝗯𝗶𝗮𝗻𝗮 𝗔𝗜 𝗦𝘁𝗮𝗿𝘀 𝗟𝗲𝗮𝗴𝘂𝗲, compuesta por: 👑 6 EQUIPOS 🎖️ 6 PRESIDENTES ⚔️ 6 ENTRENADORES 🧠 7 JUGADORES por equipo 🔥 Todos listos para competir, aprender y dejar huella. Y al mando de esta federación pionera está su líder: 👑 Antony Tabima, 𝗲𝗹 𝗽𝗿𝗶𝗺𝗲𝗿 𝗽𝗿𝗲𝘀𝗶𝗱𝗲𝗻𝘁𝗲 𝗼𝗳𝗶𝗰𝗶𝗮𝗹 𝗱𝗲 𝘂𝗻𝗮 𝗙𝗲𝗱𝗲𝗿𝗮𝗰𝗶𝗼́𝗻 𝗡𝗮𝗰𝗶𝗼𝗻𝗮𝗹 𝗔𝗜 𝗦𝘁𝗮𝗿𝘀 𝗟𝗲𝗮𝗴𝘂𝗲, un visionario que representa el fuego del talento colombiano y la fuerza de un nuevo futuro. 🎯 La visión es clara: Cada país tendrá su 𝗙𝗲𝗱𝗲𝗿𝗮𝗰𝗶𝗼́𝗻 𝗡𝗮𝗰𝗶𝗼𝗻𝗮l con sus 6 equipos, compitiendo en 𝗹𝗶𝗴𝗮𝘀 𝗶𝗻𝘁𝗲𝗿𝗻𝗮𝘀, formando talento, creando impacto… Y luego, los mejores irán a los torneos internacionales: 🌍 La 𝗖𝗵𝗮𝗺𝗽𝗶𝗼𝗻𝘀 𝗟𝗲𝗮𝗴𝘂𝗲 de la IA 🏆 Y el 𝗠𝘂𝗻𝗱𝗶𝗮𝗹 𝗱𝗲 𝗹𝗮 𝗔𝗜 Stars League 🎬 𝗬 𝗲𝘀𝗼 𝗻𝗼 𝗲𝘀 𝘁𝗼𝗱𝗼... 𝗖𝗮𝗱𝗮 𝘀𝗲𝗺𝗮𝗻𝗮 𝗽𝗿𝗲𝘀𝗲𝗻𝘁𝗮𝗿𝗲𝗺𝗼𝘀 𝘂𝗻 𝗲𝗾𝘂𝗶𝗽𝗼 𝗰𝗼𝗺𝗽𝗹𝗲𝘁𝗼, con sus jugadores, su presidente, su entrenador, sus colores y su visión. Porque cada equipo no es solo una formación... 𝗘𝘀 𝘂𝗻𝗮 𝗯𝗮𝗻𝗱𝗲𝗿𝗮, 𝘂𝗻𝗮 𝗵𝗶𝘀𝘁𝗼𝗿𝗶𝗮, 𝘂𝗻𝗮 𝗰𝗵𝗶𝘀𝗽𝗮 𝗱𝗲𝗹 𝗻𝘂𝗲𝘃𝗼 𝗺𝘂𝗻𝗱𝗼 𝗾𝘂𝗲 𝗲𝘀𝘁𝗮𝗺𝗼𝘀 𝗰𝗼𝗻𝘀𝘁𝗿𝘂𝘆𝗲𝗻𝗱𝗼. Que Colombia sea la primera no es casualidad… Es un símbolo de 𝗰𝗼𝗿𝗮𝗷𝗲, 𝘁𝗮𝗹𝗲𝗻𝘁𝗼 𝘆 𝘃𝗶𝘀𝗶𝗼́𝗻. Y 𝘂𝗻 𝗹𝗲𝗴𝗮𝗱𝗼 𝗾𝘂𝗲 𝗲𝗺𝗽𝗶𝗲𝘇𝗮 𝗮 𝗲𝘀𝗰𝗿𝗶𝗯𝗶𝗿𝘀𝗲 𝗰𝗼𝗻 𝗳𝘂𝗲𝗴𝗼 𝘆 𝗳𝘂𝘁𝘂𝗿𝗼. 🌐 La Liga está creciendo de forma exponencial. 🎓 El talento sube de nivel. 💥 Los retos se multiplican. 🎭 El espectáculo se convierte en movimiento global. ¡𝗙𝗘𝗟𝗜𝗖𝗜𝗗𝗔𝗗𝗘𝗦 𝗖𝗢𝗟𝗢𝗠𝗕𝗜𝗔! Hoy no nace una federación… H𝗢𝗬 𝗦𝗘 𝗘𝗡𝗖𝗜𝗘𝗡𝗗𝗘 𝗨𝗡𝗔 𝗟𝗟𝗔𝗠𝗔 𝗤𝗨𝗘 𝗜𝗡𝗦𝗣𝗜𝗥𝗔𝗥𝗔́ 𝗔 𝗧𝗢𝗗𝗔 𝗟𝗔𝗧𝗜𝗡𝗢𝗔𝗠𝗘́𝗥𝗜𝗖𝗔 𝗬 𝗘𝗟 𝗠𝗨𝗡𝗗𝗢. Porque no somos una comunidad… ¡𝗦𝗢𝗠𝗢𝗦 𝗨𝗡 𝗠𝗢𝗩𝗜𝗠𝗜𝗘𝗡𝗧𝗢!

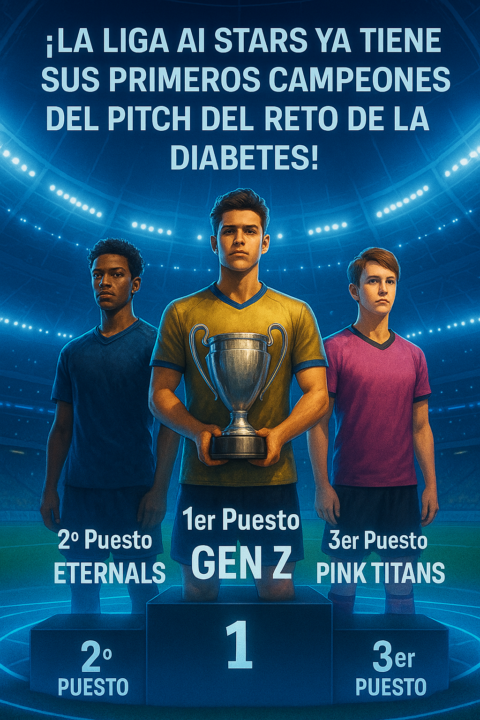

🔥 ¡𝗟𝗮 𝗟𝗶𝗴𝗮 𝗔𝗜 𝗦𝗧𝗔𝗥𝗦 𝘆𝗮 𝘁𝗶𝗲𝗻𝗲 𝘀𝘂𝘀 𝗽𝗿𝗶𝗺𝗲𝗿𝗼𝘀 𝗰𝗮𝗺𝗽𝗲𝗼𝗻𝗲𝘀 𝗱𝗲𝗹 𝗣𝗶𝘁𝗰𝗵 𝗱𝗲𝗹 𝗿𝗲𝘁𝗼 𝗱𝗲 𝗹𝗮 𝗱𝗶𝗮𝗯𝗲𝘁𝗲𝘀! 🔥

En una jornada que marcó el inicio de una nueva era en la educación en inteligencia artificial, los equipos se enfrentaron en el campo del pitch con innovación, pasión y propósito. Hoy, celebramos a quienes se han ganado su lugar en la historia: 🥇 𝟭𝗲𝗿 𝗣𝘂𝗲𝘀𝘁𝗼: 𝗚𝗘𝗡 𝗭 Una generación decidida a transformar el mundo. Han demostrado que el talento joven, bien guiado, puede liderar revoluciones. 🥈 𝟮º 𝗣𝘂𝗲𝘀𝘁𝗼: 𝗘𝗧𝗘𝗥𝗡𝗔𝗟𝗦 Estrategas con visión atemporal. Su presentación fue una obra maestra de inteligencia y propósito. 🥉 𝟯𝗲𝗿 𝗣𝘂𝗲𝘀𝘁𝗼: 𝗣𝗜𝗡𝗞 𝗧𝗜𝗧𝗔𝗡𝗦 Determinación, creatividad y valentía. Un equipo que rugió con fuerza y conquistó con estilo. ⚡👏 ¡𝗙𝗲𝗹𝗶𝗰𝗶𝗱𝗮𝗱𝗲𝘀 𝗮 𝘁𝗼𝗱𝗼𝘀 𝗹𝗼𝘀 𝗽𝗮𝗿𝘁𝗶𝗰𝗶𝗽𝗮𝗻𝘁𝗲𝘀! Habéis demostrado que el verdadero poder de la IA nace del coraje, la colaboración y las ganas de transformar el mundo. Cada pitch fue una chispa de genialidad. ¡Lo habéis hecho increíble, guerreros! 🛡️🔥 Estos resultados son solo el comienzo. En la Liga AI STARS no se compite por ego, se compite por dejar un legado. 🚀 La batalla por un lugar en nuestra incubadora ha comenzado. 🌍 Seguimos construyendo una nueva educación descentralizada, basada en retos reales, colaboración global y tecnología al servicio del bien común. 𝗡𝗼 𝘀𝗼𝗺𝗼𝘀 𝘂𝗻𝗮 𝗰𝗼𝗺𝘂𝗻𝗶𝗱𝗮𝗱, 𝘀𝗼𝗺𝗼𝘀 𝘂𝗻 𝗺𝗼𝘃𝗶𝗺𝗶𝗲𝗻𝘁𝗼. Uno que ha venido a cambiar las reglas del juego. #AIStars #PitchBattle #EducaciónDelFuturo #Startheon #InteligenciaArtificial #IAConPropósito #LegadoAI #RevoluciónEducativa #InnovaciónGlobal #DesafíosReales

1-10 of 11

Active 294d ago

Joined Mar 11, 2025

Powered by